Au cours des trente dernières années, la puissance de calcul à l’échelle planétaire n’a cessé de croître de manière exponentielle. Cette croissance, initialement tirée par l’amélioration continue des processeurs, des mémoires et des systèmes de stockage, s’est amplifiée avec l’avènement du cloud computing, des architectures distribuées et, plus récemment, de l’intelligence artificielle. L’année après année, des quantités toujours plus importantes de données ont été traitées, analysées et utilisées pour entraîner des modèles de plus en plus sophistiqués. Le résultat est un paysage technologique en perpétuelle mutation, dans lequel la puissance de calcul est devenue un enjeu stratégique à l’échelle industrielle, économique et géopolitique.

Parallèlement, l’essor des Large Language Models (LLM) a introduit un nouvel indicateur de coût : le prix du « token ». Désormais, l’entraînement et l’utilisation des LLM, qu’ils soient proposés en mode SaaS par des acteurs du cloud ou développés en interne, impliquent des coûts calculés au nombre de tokens traités. Cette métrologie souligne non seulement la valeur de la ressource informatique, mais révèle aussi la complexité des arbitrages budgétaires et stratégiques. Les entreprises, les centres de recherche et les gouvernements doivent évaluer avec précision le retour sur investissement, la qualité des modèles, et l’impact financier d’une utilisation massive de ces technologies.

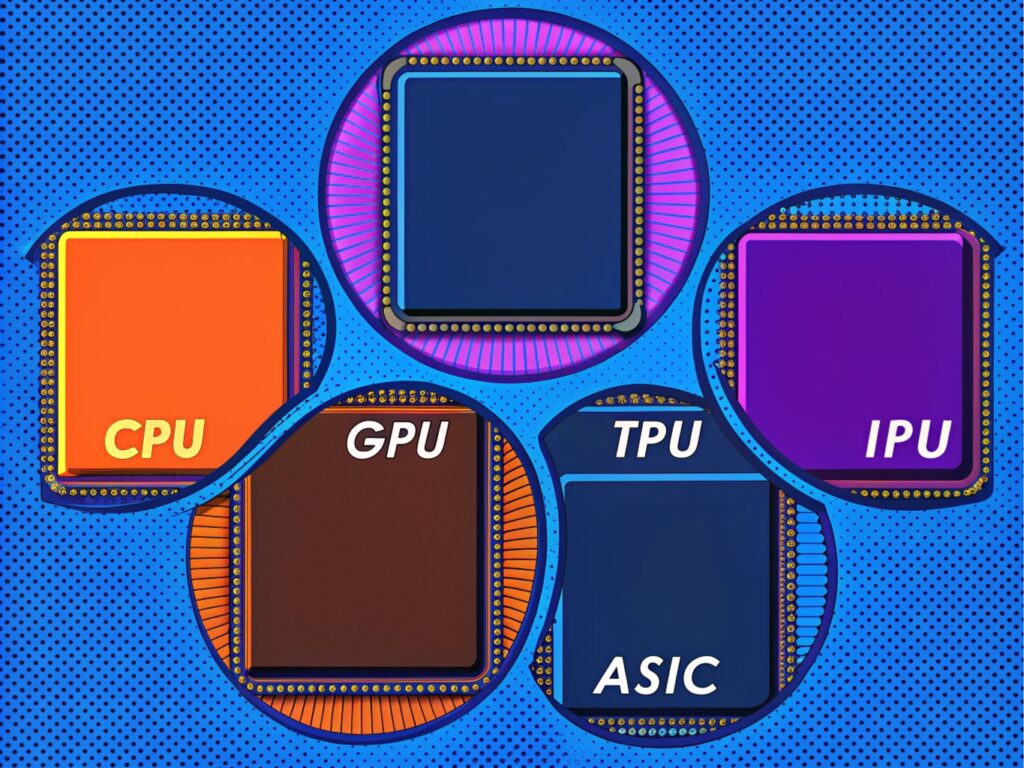

Enfin, ce panorama ne serait pas complet sans évoquer le bouleversement induit par la nouvelle génération de puces dédiées à l’IA, allant des GPU traditionnels aux TPU, NPU, IPU, et autres ASIC spécialisés. Ces circuits, développés par les géants du numérique mais aussi par une myriade d’acteurs émergents, redéfinissent la chaîne de valeur du hardware, permettant des optimisations inédites dans les calculs massifs et favorisant l’émergence de nouveaux écosystèmes. Cette recomposition du paysage technologique n’est pas neutre : elle influe sur les rapports de force entre entreprises, sur la souveraineté numérique, et sur la capacité de chaque acteur à se positionner dans la course mondiale à l’innovation.

Dans cet article, nous analyserons l’évolution de la puissance de calcul planétaire sur trois décennies, son lien avec le coût des tokens dans l’usage des LLM, et enfin l’impact stratégique des nouvelles générations de puces IA sur le marché, l’innovation et la compétitivité.

Comprendre la croissance de la puissance de calcul sur 30 ans

Les années 1990 : la montée en puissance du microprocesseur

À la fin des années 1990, la révolution informatique était déjà bien entamée. Les microprocesseurs, guidés par la loi de Moore, voyaient leur nombre de transistors doubler tous les dix-huit à vingt-quatre mois. La puissance de calcul était alors surtout localisée dans les serveurs d’entreprises, les data centers émergeants, et, dans une moindre mesure, les ordinateurs individuels. Les processeurs x86, dominés par Intel, constituaient la norme. Les gains en performance provenaient principalement de l’augmentation de la fréquence d’horloge et de l’optimisation du pipeline d’exécution des instructions. Les supercalculateurs restaient l’apanage des grandes organisations scientifiques et militaires, et la quantité de données traitées, bien que croissante, était encore sans commune mesure avec ce que nous connaissons aujourd’hui.

Les années 2000 : l’avènement du cloud et de la virtualisation

La première décennie du XXIe siècle a marqué le début du cloud computing. Les entreprises n’avaient plus besoin de posséder physiquement leurs serveurs, elles pouvaient louer de la puissance de calcul à la demande. Des acteurs comme Amazon Web Services, Google Cloud Platform, et plus tard Microsoft Azure, ont proposé une mutualisation des ressources, une flexibilité et une élasticité sans précédent. La virtualisation des serveurs, la standardisation des architectures, et la démocratisation de la bande passante Internet ont permis une croissance massive de la capacité de calcul accessible à une multitude d’acteurs.

Cette évolution a été accompagnée par l’essor des architectures massivement parallèles. Les puces multi-cœurs, le recours aux GPU pour les calculs génériques, et l’adoption de frameworks distribués ont permis d’accélérer des tâches autrefois coûteuses. Le résultat : une explosion de la puissance de calcul globale, non seulement concentrée dans les grands data centers, mais accessible à la demande via des API, des services managés et des plateformes applicatives.

Les années 2010 : Big Data, IA et edge computing

La décennie suivante a vu la popularisation du Big Data et l’explosion des données produites par les smartphones, les objets connectés, les réseaux sociaux, et les plateformes de streaming. L’analyse de ces flux massifs a stimulé le déploiement d’infrastructures toujours plus puissantes. On a alors observé le passage à l’échelle de clusters géants, avec la multiplication des nœuds de calcul, la sophistication des algorithmes de répartition de charge, et la montée en puissance du edge computing, où une partie de la puissance de calcul est déportée au plus près des utilisateurs finaux.

Simultanément, l’essor du Machine Learning et des réseaux de neurones profonds (Deep Learning) a introduit de nouveaux besoins en termes de calcul. L’entraînement de modèles complexes, comme ceux utilisés en vision par ordinateur, en traitement du langage naturel ou en recommandation de contenus, a exigé une puissance exponentielle, tant en calcul qu’en stockage. Les supercalculateurs IA sont devenus une réalité, intégrant des dizaines de milliers de GPU ou des puces spécialisées.

Les années 2020 et au-delà : l’hyper-échelle et la spécialisation

Les années 2020 marquent une nouvelle ère : celle de l’hyper-échelle. Les grands fournisseurs cloud ont construit des infrastructures gigantesques, avec des quantités astronomiques de CPU, de GPU, de TPU, et autres puces spécialisées, permettant d’entraîner des modèles de plus en plus volumineux. Les LLM, comme GPT-3, GPT-4, PaLM ou LLaMA, ont repoussé les limites du possible, nécessitant des flottes entières de serveurs pour traiter des milliards de paramètres. Cette course à la puissance est aujourd’hui le moteur de l’innovation, mais aussi des préoccupations environnementales, économiques et politiques.

Parallèlement, l’écosystème s’est spécialisé. Des entreprises développent des ASIC dédiés à des opérations IA spécifiques. Les FPGA (Field Programmable Gate Array) offrent une flexibilité pour adapter la logique matérielle aux besoins des algorithmes. Les architectures neuromorphiques, inspirées du cerveau humain, ouvrent la voie à une nouvelle génération de calcul. Dans ce contexte, la puissance de calcul mondiale continue de croître, mais se complexifie, devenant une ressource dont la gestion est stratégique.

Le coût des tokens et l’utilisation des LLM

Comprendre le principe du token

Les Large Language Models, en tant qu’outils de génération ou de compréhension du langage, traitent l’information sous forme de tokens. Un token est une unité de texte, qui peut être un mot, un sous-mot, ou même un caractère, selon le modèle et la méthode de tokenisation. Les LLM, entraînés sur des centaines de milliards de tokens, doivent non seulement assimiler des connaissances, mais aussi être capables de générer des réponses cohérentes, informatives et contextuelles.

La consommation de tokens s’observe à plusieurs niveaux : l’entraînement du modèle, qui consiste à ingérer de gigantesques jeux de données textuelles, et l’inférence, c’est-à-dire l’utilisation du modèle pour répondre à des requêtes. Chaque requête, chaque prompt, chaque réponse génère un nombre de tokens traités, et ce nombre est directement lié au coût facturé par les fournisseurs de LLM. Le prix du token devient donc un indicateur clé de la rentabilité et de l’échelle d’utilisation de ces systèmes.

L’évolution du coût du token : Au début, lorsque les premiers modèles de grande taille sont apparus, le coût du token était relativement élevé. Les infrastructures n’étaient pas encore optimisées, les modèles n’étaient pas déployés à grande échelle, et les processus d’inférence manquaient d’optimisation. Avec la maturité de la technologie, l’entrée en scène de concurrents et l’amélioration des hardware, les coûts ont commencé à baisser. On a assisté à une course à l’efficacité, visant à réduire le temps d’inférence, à compresser ou quantifier les modèles, et à amortir les coûts de développement sur une base d’utilisateurs plus large.

Aujourd’hui, la tarification au token permet aux entreprises d’ajuster leur consommation. Un acteur cherchant à analyser des millions de documents ou à générer du contenu en masse devra budgéter précisément ses dépenses. Les optimisations logicielles, l’émergence de modèles open source plus légers et la concurrence entre fournisseurs poussent encore les prix à la baisse. Pourtant, le coût demeure un facteur critique, influant sur les choix technologiques, la sélection des partenaires cloud, ou la décision d’entraîner son propre modèle plutôt que d’utiliser une solution externalisée.

Les arbitrages budgétaires et la rentabilité

Le coût en tokens met en lumière des arbitrages stratégiques : vaut-il mieux utiliser un modèle plus performant mais plus cher, ou un modèle moins coûteux mais potentiellement moins précis ? Faut-il entraîner son propre modèle, ce qui implique un investissement initial colossal, mais permet de réduire le coût marginal à long terme, ou faire appel à un prestataire externe, ce qui offre de la flexibilité mais enferme dans une relation de dépendance ?

La réponse varie selon le secteur d’activité, le volume de données à traiter, la sensibilité des informations manipulées (données confidentielles, informations médicales, etc.), et la nature des cas d’usage. Le coût en tokens devient ainsi un indicateur de maturité du marché, reflétant la tension entre la demande, l’offre, les capacités matérielles et la sophistication logicielle.

L’évolution des chips IA et les enjeux stratégiques

De la domination du CPU/GPU aux puces spécialisées

Historiquement, le calcul informatique de haute performance (HPC) s’appuyait principalement sur des CPU et des GPU. Les GPU, grâce à leur architecture massivement parallèle, ont permis des gains spectaculaires dans les tâches de Deep Learning. Toutefois, l’émergence des LLM et des applications IA avancées a révélé la nécessité de puces plus spécialisées, capables d’accélérer les opérations arithmétiques spécifiques au Machine Learning, de réduire la consommation énergétique, et de s’adapter aux besoins de la quantification des modèles, de l’entraînement distribué ou de l’inférence temps réel.

Les Tensor Processing Units (TPU) de Google, par exemple, ont été conçus pour accélérer les calculs de matrice typiques du Deep Learning. D’autres entreprises, comme Graphcore (IPU), Habana Labs (Gaudi), Cerebras, Nvidia (avec ses GPU de plus en plus spécialisés), ou encore des start-up chinoises, proposent des circuits conçus sur mesure pour l’IA. Cette diversité de l’offre reflète une fragmentation du marché, où chaque acteur tente de tirer son épingle du jeu en optimisant un sous-ensemble précis des charges de travail IA.

Les enjeux stratégiques pour les entreprises

La disponibilité et la performance de ces puces IA sont devenues un facteur clé de différenciation pour les entreprises. Disposer de la puce la plus adaptée permet d’entraîner plus vite un LLM, de réduire le coût par token, d’améliorer le temps de réponse, ou de traiter un flux de données plus important. Les géants du cloud maîtrisent leur propre pile matérielle, réduisant leur dépendance vis-à-vis des fournisseurs de puces. Les entreprises clientes, elles, doivent choisir entre louer ces ressources auprès des hyperscalers, investir dans leur propre infrastructure, ou opter pour des solutions hybrides.

Ce choix n’est pas uniquement technique : il engage la souveraineté numérique. Les puces IA, en raison de leur complexité et de leurs matériaux, soulèvent des questions d’approvisionnement, de chaînes logistiques, et de sécurité nationale. Certains pays cherchent à encourager la production locale ou à établir des partenariats stratégiques avec des fournisseurs de premier plan. Ainsi, la disponibilité des puces IA n’est pas seulement un enjeu technique, mais un véritable bras de fer géopolitique, influençant le leadership technologique, la compétitivité industrielle, et la sécurité économique.

L’impact sur l’innovation et la recherche

L’accès à ces puces spécialisées influence aussi la recherche. Les laboratoires académiques, les start-up et les PME peuvent tirer parti de la puissance massive offerte par ces accélérateurs pour explorer de nouveaux modèles, de nouvelles approches, et des architectures de Deep Learning plus efficaces. Inversement, le manque d’accès à certaines technologies, pour des raisons de coûts, de disponibilités, ou de régulations, peut freiner l’innovation. Les projets open source, les initiatives de mutualisation des ressources, et les centres de calcul publics deviennent alors des points d’appui cruciaux pour conserver un écosystème dynamique et inclusif.

La lutte pour la propriété intellectuelle et la standardisation

Avec l’expansion du marché des puces IA, la propriété intellectuelle et la standardisation deviennent stratégiques. Les brevets, les designs de référence, les frameworks logiciels capables d’exploiter ces puces sont des leviers de contrôle et de monopole potentiel. Les entreprises qui parviennent à imposer leurs solutions comme standard de facto, à attirer une large communauté de développeurs, ou à sécuriser la chaîne logistique des matériaux critiques, gagnent un avantage concurrentiel difficile à rattraper.

Les perspectives futures : les Chips IA

Une complexité croissante

L’ensemble de ces dynamiques – croissance exponentielle de la puissance de calcul, pression sur le coût des tokens dans l’utilisation des LLM, et diversification des puces IA – aboutit à un paysage extraordinairement complexe. Les acteurs doivent jongler entre des contraintes financières, des considérations techniques, des enjeux de souveraineté et de propriété intellectuelle. Cette complexité appelle à de nouvelles compétences, à une meilleure gouvernance technologique, et à un dialogue renforcé entre les ingénieurs, les décideurs, les régulateurs, et les communautés scientifiques.

L’optimisation des ressources

Face à l’augmentation des besoins en calcul, l’optimisation devient un maître-mot. Il ne s’agit plus seulement de déployer plus de serveurs ou plus de puces, mais de mieux les utiliser : réduire la consommation énergétique, paralléliser intelligemment les tâches, adapter finement la topologie des réseaux de neurones, ou développer des méthodes d’entraînement plus efficaces. Les techniques de compression, de distillation de modèles, ou d’apprentissage fédéré peuvent aider à contenir les coûts, réduire le coût par token, et limiter l’empreinte carbone.

Une redistribution des cartes

L’évolution rapide des technologies de calcul rééquilibre sans cesse le rapport de force entre les acteurs. Ceux qui investissent massivement dans l’infrastructure et le développement de puces IA sur-mesure renforcent leur position dominante. Les acteurs plus modestes doivent nouer des alliances, innover dans des niches, ou miser sur le logiciel et les modèles open source pour se différencier. Les consommateurs finaux, quant à eux, bénéficient d’un écosystème plus riche, mais doivent naviguer dans un paysage où la qualité, le coût et la disponibilité varient grandement d’un fournisseur à l’autre.

Le mot de la fin

En trente ans, la puissance de calcul mondiale a connu une ascension fulgurante, alimentée par l’essor du cloud, de l’IA et de l’innovation matérielle. Les LLM symbolisent aujourd’hui cette nouvelle ère, où le coût des tokens reflète la valeur d’une ressource informatique rare et précieuse. Parallèlement, l’arrivée des puces IA spécialisées rebat les cartes, offrant un levier stratégique à ceux qui maîtrisent l’ensemble de la chaîne, du silicium aux algorithmes. Les entreprises, les gouvernements, les chercheurs et les régulateurs doivent composer avec ces dynamiques, en cherchant à concilier performance, coût, souveraineté et innovation.

L’avenir s’annonce complexe, mais porteur de promesses. L’IA, soutenue par une puissance de calcul toujours plus grande, est appelée à bouleverser des secteurs entiers, à transformer la manière dont nous interagissons avec la technologie, et à ouvrir de nouvelles perspectives créatives. Le défi consiste à façonner cet écosystème de manière responsable, équitable et durable, afin que la promesse de l’IA et de la puissance de calcul profite au plus grand nombre.

Sources et ressources :

- OpenAI Research Blog : https://openai.com/blog/

- Google Cloud TPU Documentation : https://cloud.google.com/tpu

- NVIDIA AI Resources : https://www.nvidia.com/en-us/ai-data-science/

- Cerebras Systems : https://www.cerebras.net/

- Graphcore Documentation : https://www.graphcore.ai/

- IEEE Spectrum, articles sur l’évolution du HPC : https://spectrum.ieee.org/

- Rapports de l’OECD sur l’IA : https://www.oecd.org/innovation/ai/

Laisser un commentaire / une idée / compléter...